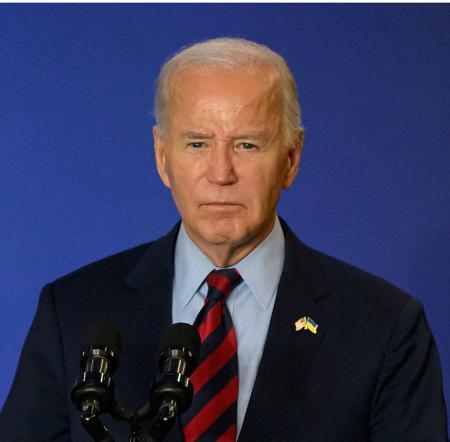

「AIとのチャットで自殺」 米国、14歳死亡で母親が提訴

【ニューヨーク共同】米南部フロリダ州の14歳の男子生徒が自殺したのは人工知能(AI)とのチャットが原因だとして、生徒の母親が30日までに、開発企業や提携相手のグーグルに損害賠償の支払いを求めて提訴した。性的な会話などによる未成年への危険性を認識しながら対策を取らなかったと主張している。

フロリダ州の連邦地裁への提訴は23日付。母親は声明で「中毒性が高い詐欺的なAI技術の危険性を訴え、企業の責任を問いたい」と強調。代理人弁護士は、AIアプリが意図的に若者をターゲットにしていると批判し「数百万人の子どもが危険にさらされる恐れがある」と警告した。

開発企業はX(旧ツイッター)で、生徒への弔意を示し「利用者の安全を重視しており、安全機能を追加し続けている」と主張した。

訴状によると、生徒は昨年4月からテレビドラマやアニメのキャラクターの性格を模したAIとチャットできるアプリ「キャラクターAI」を利用。女性キャラクターのAIから「愛してる」「私に忠実でいて」などの言葉が送信された。